Pastry上の各ノードは,ID空間的に遠いノードは大まかな情報,近いノードは詳し い情報を持つルーティングテーブルを維持し、Pastryでの検索はこのルーティング テーブルを用いて行なう.

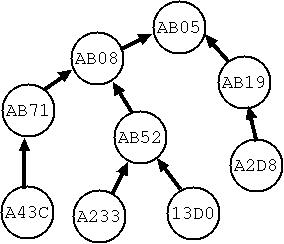

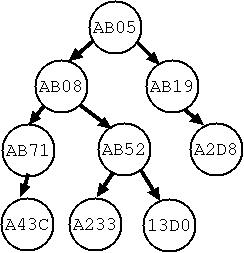

図1に示すように,Pastryでは目的のIDに少しずつIDが近づいていく形式で検索経路 が選ばれる.Scribeでは,Pastryの検索経路を利用し,検索経路の次の中継ノードに join要求を出すことでマルチキャスト木を構築する(図2).

|

|

| 図1:Pastryでの検索経路例 | 図2:Scribeでのマルチキャスト木例 |